Le mercredi 22 octobre, les médias français relaient la pétition de 800 personnalités politiques, entrepreneurs tech, célébrités et scientifiques sur les dangers de « la Super Intelligence Artificielle », capable de « surpasser les capacités humaines », et appelant à l’arrêt immédiat des travaux visant son développement. Ce genre d’annonce est récurrent en dépit de tous les articles scientifiques montrant que les modèles d’IA n’arrivent pas à atteindre les capacités de raisonnements d’un être humain sur des tests mathématiques élémentaires. Sur ce sujet, voir :

- mon article sur les difficultés des IA sur ces types de tests (dont les matrices de Raven)

- et pour des articles techniques, celui de six chercheurs d’Apple d’octobre 2024 (GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models) à la conclusion accablante : « Nous n’avons trouvé aucune preuve de raisonnement formel dans les modèles de langage. Leur comportement s’explique mieux expliqué par une corrélation sophistiquée des modèles, et si fragile, en réalité, que changer un mot peut modifier les résultats de ~10%! » ; celui de Gary Marcus « LLMs don’t do formal reasoning - and that is a HUGE problem » ; et l’étude plus récente « Do AI Models Perform Human-like Abstract Reasoning Across Modalities?», du groupe de chercheurs travaillant avec Melanie Mitchell (2 octobre 2025).

Rappelons donc que la « Super Intelligence Artificielle » est un mythe agité par des entrepreneurs intéressés ou des gogos, que l’appellation « d’intelligence artificielle » est déjà elle-même une imposture (voir mon article expliquant le fonctionnement de tous des robots comme ChatGPt).

Ces prédictions miribolantes devraient quand même être tempérées par des constats plus prosaïques : voir l’article du 21 octobre 2025, Pour s’informer, les IA comme ChatGPT ne sont pas dignes de confiance, relatant l’étude réalisée par vingt-deux médias publics de dix-huit pays (l’IA est incapable de distinguer l’information d’une chronique humouristique, elle invente des détails, donne de mauvaises dates, etc.) ; voir les preuves de réponses fantaisistes accompagnées de “mensonges” assurant qu’elles sont bien tirées des sources alléguées, et autres comportements erratiques dans l’article de Melanie Mitchell Why AI chatbots lie to us (paru dans Science le 24 Juillet 2025).

Les scénarios techno-catastrophiques périodiquement annoncés par les géants du numérique sont des écrans de fumée. Leur objectif est double : 1° obtenir toujours plus d’investissements (“aidez-nous à développer des IA capables de contrôler ces monstres”) ; 2° éviter toute régulation politique de leur activité en détournant l’attention du public et des pouvoirs publics des menaces et difficultés bien réelles liés aux utilisations de l’IA.

Cet article aborde quelques-unes de ces menaces et difficultés, déjà bien documentées.

I. IA et Big data. Vers un monde orwellien ?

Être surveillé tout le temps et partout

Les nouvelles formes de surveillance et de contrôle que permettent l’IA et les Big Data rendent notre monde de plus en plus semblable au monde dystopique imaginé par Orwell dans 1984, dans lequel un gouvernement totalitaire contrôle ses citoyens par la surveillance généralisée, la manipulation de l’information et la répression.

IA et Big data

Beaucoup d’outils de surveillance utilisés aujourd’hui restent classiques, l’innovation technique les a seulement rendus plus efficaces et plus discrets : micros et systèmes d’écoute, logiciels espions et trackers, activation à l’insu des utilisateurs des micro et caméra de leur smartphone, vidéosurveillance sur les lieux publics et privés. Si l’IA ne change pas tout, la nouveauté c’est le Big data (la collecte de données massives) et le data mining, c’est-à-dire l’extraction d’informations utiles à partir de ces ensembles de données grâce aux puissants algorithmes statistiques et analytiques de l’IA. La nouveauté, c’est aussi que les individus fabriquent eux-mêmes leur « dossier numérique ». D’abord, en consentant à l’enregistrement de leurs données à travers toutes sorte d’objets connectés : smartphones, PC, tablettes, enceintes et assistant vocaux, TV intelligente, montres, vélos, appareils ménagers, etc., dont beaucoup « écoutent » et enregistrent en permanence. Peu de personnes ont conscience de la quantité de données qu’elles acceptent de divulguer, via les paramètres de ces objets (les smartphones en particulier) et l’installation d’applications (qui lit les mentions légales avant d’en installer une ?)1. Ensuite, en exposant leur vie (leur « story »), en partageant volontairement toutes sortes de photos et d’informations personnelles sur les réseaux sociaux, sur leur blog, leurs pages personnelles, sans qu’aucun Big Brother ne les y contraigne ou n’ait d’efforts à faire pour les acquérir. Les GAFAM — Google (Alphabet), Apple, Facebook (Meta), Amazon et Microsoft — et leurs satellites (WhatsApp, Instagram, X, TikTok, Snapchat) accomplissent le fantasme des régimes autoritaires et des entreprises capitalistes : que les citoyens-consommateurs livrent d’eux-mêmes une masse d’informations personnelles qu’ils se chargeront d’agréger et d’exploiter « pour leur bien ». Les GAFAM sont aussi prêts à livrer ces données à toute dictature qui menacerait de les interdire sur son territoire. Tout cela nous rend dociles (on s’habitue à consentir), vulnérables, et complices de l’utilisation à grande échelle des instruments de contrôle et d’asservissement, puisque non seulement nous les acceptons, mais nous en usons en permanence à travers les avis, les étoiles, servant à « évaluer » les restaurants, les livreurs, les chauffeurs de taxis, etc., que nous déposons volontiers ou consultons.

Intérêt de la métaphore orwellienne

Daniel Solove dans The Digital Person : Technology and Privacy in the Information Age, souligne à juste titre que les Big Brothers d’aujourd’hui n’ont pas intérêt à ce que nous les percevions comme une menace. Ils veulent au contraire être aimés. La métaphore orwellienne serait obsolète. Cette conclusion, trop rapide, est erronée. D’abord, parce que la bienveillance des GAFAM ne dure que tant que dure notre consentement à leur pouvoir. En témoigne, la violence de leurs attaques contre les tentatives de régulation étatique ou supra-étatique (l’Union Européenne) de leurs activités. Ensuite, parce que les régimes totalitaires (Russie, Chine, Iran, Corée du Nord) ou autoritaires (Turquie, Arabie Saoudite, Singapour, Biélorussie, Birmanie, etc.) se servent de l’IA pour manipuler, surveiller et réprimer leurs opposants d’une façon classiquement orwellienne : désinformation, contrôle des médias, surveillance des individus, enlèvements, rééducation, disparitions, tortures, procès politiques). Enfin, parce que dans 1984, le dictateur d’Océania, Big Brother, travaille à supprimer l’idée même de révolte de l’esprit de ses sujets par la manipulation de l’information, la réécriture de l’histoire (comme aujourd’hui en Inde, en Chine, en Russie, et désormais aux États-Unis), et une révision de la langue pour en faire disparaître tous les termes politiquement incorrects ou subversifs, dans l’espoir que l’idée même d’une critique, d’une opposition ou d’une révolte ne puisse plus se développer dans l’esprit (j’y reviens ensuite).

Orwell, Bentham, Foucault

Projet Panopticon ©The Architecture Competitions Platform

Orwell expose dès le début de son roman le principe des sociétés de surveillance. Pour soumettre des individus, la force n’est pas nécessairement requise. La crainte d’être vu suffit à les tenir. Et la surveillance n’a même pas besoin d’être permanente car l’essentiel est que les individus se croient surveillés.

Le télécran recevait et transmettait simultanément. Il captait tous les sons émis par Winston au-dessus d’un chuchotement très bas (…). [Il] pouvait être vu aussi bien qu’entendu. Naturellement, il n’y avait pas moyen de savoir si, à un moment donné, on était surveillé. Combien de fois, et suivant quel plan, la Police de la Pensée se branchait-elle sur une ligne individuelle quelconque, personne ne pouvait le savoir. On pouvait même imaginer qu’elle surveillait tout le monde, constamment. Mais de toute façon, elle pouvait mettre une prise sur votre ligne chaque fois qu’elle le désirait. On devait vivre, on vivait, car l’habitude devient instinct, en admettant que tout son émis était entendu et que, sauf dans l’obscurité, tout mouvement était perçu. (Orwell, 1984)

1984 applique à la société du principe d’architecture carcérale imaginé par Jeremy Bentham dans son Panopticon2 (1791). Où qu’ils se trouvent les prisonniers peuvent toujours être vus par des surveillants qu’ils ne peuvent pas voir. Foucault analyse le dispositif dans Surveiller et Punir [Gallimard, 1975, SP désormais] :

L’effet majeur du Panoptique : induire chez le détenu un état conscient et permanent de visibilité qui assure le fonctionnement automatique du pouvoir. Faire que la surveillance soit permanente dans ses effets, même si elle est discontinue dans son action. [SP, 202]

Dispositif important, car il automatise et désindividualise le pouvoir. Celui-ci a son principe moins dans une personne que […] dans un appareillage dont les mécanismes internes produisent le rapport dans lequel les individus sont pris. […] Il y a une machinerie qui assure la dissymétrie, le déséquilibre, la différence. Un assujettissement réel naît mécaniquement d’une relation fictive. De sorte qu’il n’est pas nécessaire d’avoir recours à des moyens de force. [SP, 203]

Orwell met aussi en évidence un effet plus subtil et envahissant. Ce type de surveillance conduit à intérioriser les normes sociales qui, bientôt, ne sont même plus perçues comme répressives « On devait vivre, on vivait, car l’habitude devient instinct ». Foucault analyse cet effet :

Celui qui est soumis à un champ de visibilité, et qui le sait, reprend à son compte les contraintes du pouvoir ; il les fait jouer spontanément sur lui-même ; il inscrit en soi le rapport de pouvoir dans lequel il joue simultanément les deux rôles ; il devient le principe de son propre assujettissement. […] Le pouvoir externe […] tend à l’incorporel ; et plus il se rapproche de cette limite, plus ces effets sont constants, profonds, acquis une fois pour toutes, incessamment reconduits : perpétuelle victoire qui évite tout affrontement physique et qui est toujours jouée d’avance. [SP, 204]

Au-delà de la prison, Foucault montre que le principe panoptique caractérise les sociétés disciplinaires :

« L’agencement panoptique programme, au niveau d’un mécanisme élémentaire et facilement transférable, le fonctionnement de base d’une société toute traversée et pénétrée de mécanismes disciplinaires ». [SP, 210]

Ce n’est pas un hasard si, le slogan le plus célèbre du régime khmer rouge était « L’Angkar a les yeux de l’ananas »3. L’aphorisme vaut avertissement : l’Angkar voit tout, l’Angkar sait tout. Pour Henri Locard,1984 décrit « nombre des mécanismes de la société polpotienne 30 ans avant qu’elle n’existe » :

[l’aphorisme de l’ananas est] « la version khmère rouge du célèbre « Big Brother is watching you » orwellien. […] Pol Pot se faisait appeler « Frère Numéro Un » ou même carrément “Big Brother”, seulement entre Khmers Rouges s’entend, puisque la population ordinaire ne le connaissait pas »4.

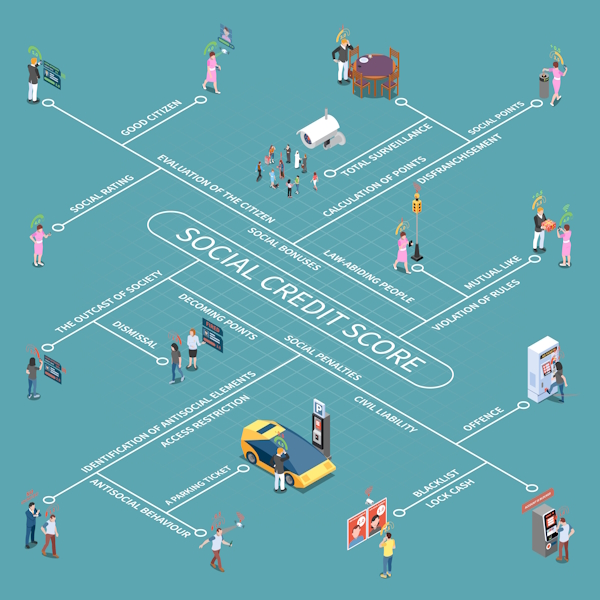

Le système du « crédit social » chinois, accomplissement du schéma orwellien

La collecte massive de données rend aujourd’hui possible un gouvernement omniscient, qui surveille ses citoyens, les espionne et les contrôle par la peur, comme on le voit en Russie et plus encore en Chine, avec le système du crédit social [SCS désormais]5. Yongxi Chen et Anne S.Y Cheung expliquent que le SCS a « pour objectif d’évaluer la fiabilité des citoyens chinois dans la tenue de leurs promesses et le respect des règles juridiques, des normes morales et des normes professionnelles et éthiques ».

Mais ils soulignent, dès 2017, leur crainte « que la totalité de la vie des individus soit enregistrée, que les citoyens soient surveillés et que l’État orwellien devienne une réalité ». Et cela d’autant plus, que les individus ne savent pas « ce qui contribue à leur score de crédit social, ignorent la façon dont il est composé […] et la façon dont leurs données sont interprétées et utilisées.6 »

Le SCS repose sur la collecte d’une myriade de données sur le comportement des citoyens chinois, dans les entreprises, dans la rue, dans les transports en commun, y compris leur respect du code de la route et leur « moralité » sur les réseaux sociaux. Les mégadonnées sont analysées par une IA qui calcule la « qualité » du citoyen et lui attribue un score, dont dépend le périmètre de ses droits. Un score trop bas peut les priver « du droit de postuler à certains emplois, d’inscrire leurs enfants dans certaines écoles ou encore de prendre les transports en commun », « l’organe de presse du gouvernement chinois, Global Times, déclarait ainsi récemment que « 11 millions de personnes avaient été empêchées de prendre l’avion, 4 millions et demi de prendre le train »7. Les convictions religieuses sont également surveillées. Appartenir aux cultes « mauvais » ou « hérétiques » (bouddhisme, islam, une dizaine d’Églises chrétiennes, Falun Gong, etc.) vaut inscription sur les listes noires du « crédit social »8.

En principe, un État démocratique ne surveille qu’à de bonnes fins : identifier des activités criminelles, cybercriminelles, pédopornographiques, etc. Mais il collecte lui aussi d’énormes quantités d’informations et dispose grâce à l’IA d’une puissance inédite de surveillance des individus, et rien ne garantit qu’une démocratie soit protégée. En 2025, on a vu comment l’administration de Donald Trump s’est servie du fichier recensant 500.000 migrants latino-américains — qui s’étaient vu accorder un statut légal sous Joe Biden — pour les identifier, les traquer, les arrêter et les expulser, après avoir purement et simplement révoqué ce statut.

Surveiller et faire punir ses semblables sans passer par la Justice

Épier ses semblables. À la surveillance verticale et hiérarchique des États, s’ajoute la surveillance horizontale et « égalitaire » de nos pairs sur les réseaux sociaux. Les « justiciers » et délateurs du Net traquent les maladresses des utilisateurs, leurs fautes et abus, supposés ou réels, pour s’en moquer, les dénoncer ou exiger leur punition, même longtemps après qu’ils se sont produits. La puissance des algorithmes de recherche facilite la recherche d’informations, y compris privées. Chacun se sentant désormais surveillé et enregistré, à des fins potentiellement malveillantes, se censure dans ce qui, initialement, était un espace de liberté.

Détruire sa vie en 63 signes. Justine Sacco, avant de prendre un avion pour Le Cap, tweete aux 500 abonnés de son compte personnel : « Going to Africa. Hope I don’t get AIDS. Just kidding. I’m white ! ». En français « En route pour l’Afrique. J’espère que je ne vais pas choper le sida. Je blague, je suis blanche ». À l’atterrissage au Cap, dix heures plus tard, elle rouvre son smartphone et découvre son licenciement. Le tweet est devenu viral. Le premier hashtag créé (#HasJustineLandedYet) agrège des milliers de tweets indignés. Le taux de partage record attire l’attention des médias en ligne qui le diffusent l’info, provoquant un lynchage médiatique.9

Licencié à cause d’une photo prise à son insu. Adama Cissé, agent de propreté à Paris est licencié après la diffusion sur les réseaux sociaux d’une photographie le montrant allongé sur rebord de vitrine, en tenue de travail, chaussures et chaussettes à côté de lui, avec ce commentaire « Voilà à quoi servent les impôts locaux des Parisiens à payer les agents de propreté à roupiller, on comprend pourquoi Paris est si dégueulasse ». Le buzz se développe, la Mairie de Paris interroge son employeur, qui décide de le licencier10.

Licenciée pour des messages « déplacés » après l’assassinat de l’influenceur trumpiste Charlie Kirk. Laura Sosh-Lightsy employée d’une université publique du Tennessee écrit sur sa page Facebook : « La haine engendre la haine. ZERO sympathie ». Une sénatrice républicaine, Marsha Blackburn, dénonce aussitôt la publication : « Cette personne devrait avoir honte (…). Elle doit être virée de son poste ». Dans la foulée, l’université annonce son licenciement.11

Ces trois affaires sont bien différentes. Elles ont pourtant deux points en commun : 1° le rôle des algorithmes d’IA dans la création, l’ampleur et la propagation du buzz médiatique ; 2° l’atteinte au droit fondamental en démocratie d’être jugé équitablement, publiquement et dans un délai raisonnable, par un juge indépendant et impartial.

Noter ses semblables. La surveillance s’exerce aussi par l’évaluation des employés des entreprises et des services publics. Nous évaluons le chauffeur UBER, le livreur Amazon, le serveur du restaurant, le médecin du quartier, le personnel de l’hôpital, et désormais, les établissements scolaires et le professeur d’université12. Les algorithmes d’IA moulinent les avis et attribuent un score pour notre plaisir et celui des employeurs. En collectant et diffusant les avis et les score, le système fait savoir et donne du pouvoir. Dans certains cas, il permet de punir ou de récompenser automatiquement, comme chez Uber.

Black Mirror ©Netflix

L’épisode Nosedive (Chute libre) de la série Black Mirror illustre plaisamment les effets de ce type de contrôle social. Dans un monde dystopique, chacun note les autres de 0 à 5 en fonction de la qualité de son interaction avec eux. Lacie, l’héroïne, chercher à augmenter son statut social pour accéder à la maison de ses rêves. À la suite d’une bévue, rien ne se passe comme prévu. Comme sa note baisse, son statut social baisse aussi, ce qui lui fait perdre des relations « intéressantes » et des privilèges (en matière de logement ou transport). Chaque baisse de note entraîne ainsi la suivante. Elle devient une paria et bientôt une délinquante. Personne n’a voulu la punir. Chacun a juste noté honnêtement sa qualité relationnelle.

Les Big Brothers contemporains ont compris la leçon d’Orwell. Plus on surveille de façon douce, invisible, moins on a besoin de recourir à la force. Ils disposent avec nous d’une armée de petites mains évaluatrices, toujours prêtes à espionner, noter et signaler, toujours à l’affût comme les « yeux de l’ananas » polpotien. Nous sommes bien proche d’adopter le système chinois du crédit social, sous un vernis démocratique.

Langage et pouvoir, censure et algorithmes

Dans 1984, Orwell développe une conception politique du langage qui va au-delà des considérations traditionnelles sur la rhétorique comme compétence politique ou moyen de manipulation. Big Brother fait travailler ses linguistes au perfectionnement de la Novlangue (le Newspeek) dont la fonction est normative :

Le but de la novlangue n’était pas seulement de fournir un moyen d’expression pour la vision du monde et les habitudes mentales propres aux dévots de l’angsoc [soc-ialisme ang-lais], mais de rendre tous les autres modes de pensée impossibles.13

Il s’agit de rendre sinon impensable, au moins inexprimable, toute pensée contraire à l’idéologie du régime. Le principal procédé principal consiste à supprimer du vocabulaire tous les « mots indésirables », de sorte que les idées critiques qui pourraient toujours germer dans un esprit, ne le puissent « que sous une forme vague, inexprimable en mots » (1984), impossible à élaborer ou communiquer. Cette conception est proche du mythe linguistique, popularisé sous le nom d’« hypothèse Sapir-Whorf »14, d’après lequel la structure d’une langue suffirait à elle seule déterminer la pensée. Ce n’est pas celle d’Orwell. Dans le roman, la Novlangue résulte d’une politique planifiée. Le pouvoir est nécessaire pour l’imposer et la maintenir en chassant et réprimant les usages qui s’en écartent.

À défaut créer une novlangue, les autocrates contemporains s’emploient à traquer eux aussi l’utilisation des « mots indésirables » pour les faire disparaître des sites officiels, de la presse, des réseaux sociaux. Cette censure à grande échelle n’est possible que par le Big Data et les algorithmes d’IA.

Dans la Russie de Poutine, il n’y a pas de « hausse des prix », seulement une « correction des prix », pas d’« opposants » seulement des « agents étrangers », pas de « guerre » en Ukraine mais une « opération militaire spéciale », pas de « déportation de civils » mais des « opérations de sauvetage » ; on ne doit pas parler de « militaires ukrainiens » mais d’« ukronazis » ou de « terroristes », de « mercenaires russes » mais de « héros de la Grande Russie ».15 Tout accès par Internet à une pensée « dissidente » est bloqué par les algorithmes d’IA dédiés à la censure.

La Chine de Xi Jinping utilise des algorithmes visant des mots-clés ou des locutions afin de censurer l’expression ou l’accès à des pensées contestataires. Par exemple : « Quitter » ou « renverser le PPC » (le Parti Communiste chinois), « Tibet libre », « Dalaï-Lama », « Pour l’amour d’Allah » (et ses nombreuse variantes) ainsi que tout ce qui se rapporte aux « Ouighours » (peuple de chinois musulmans), « dictature », « Tiananmen », « 4 juin » (date des manifestations de Tiananmen), « Ferme des animaux » et « 1984 » (pour des raisons évidentes), « Xi-Zedong » (contraction de Xi Jinping + Mao Zedong), « Winnie l’ourson » (dont le physique est comparé à celui de Xi Jinping)16.

Depuis la prise de fonctions de Donald Trump, des centaines de mots et de locutions ont été bannis des communications officielles de l’administration américaine. Le 7 mars dernier, le New York Times17 publiait la liste d’environ 200 mots « déconseillés » par l’administration Trump pour l’ensemble des acteurs publics des États-Unis, sans distinction. La censure idéologique vise la Justice sociale (égalité sociale, égalité des chance, discrimination, stéréotypes, exclusion, sont proscrits), la diversité et les minorités (ethnique, diversité / mixité ethnique, multiculturel, racisme, ségrégation), l’égalité homme-femme, l’orientation sexuelle, l’écologie, etc.

La purge des mots « inappropriés » vise un usage « politiquement correct » de la langue, c’est-à-dire conforme aux valeurs et à l’idéologie des censeurs du moment. Les régimes totalitaires semblent partager la métaphysique qui préside à la création de la novlangue : « Nous contrôlons la matière parce que nous contrôlons l’esprit. La réalité est à l’intérieur du crâne », « Tout ce qui se passe est dans l’esprit. Et tout ce se passe dans l’esprit, se passe effectivement » (1984). Cette métaphysique fonde aussi l’idée de « vérité alternative » et la pratique des « fake-news ».

II. Automatisation des décisions. Vers un monde kafkaïen ?

Être accusé sans savoir pourquoi, ni par qui

Quelqu’un a dû raconter des histoires sur Joseph K., car un matin, sans avoir rien fait de mal, il a été arrêté. (Kafka, Le Procès)

Je suppose que l’ordinateur s’est trompé. (Joseph K. au 21e siècle)18

Dans Le Procès, Joseph K. reçoit un beau matin la visite inattendue de trois agents qui l’informent de son d’arrestation. K. ne comprend pas pourquoi et compte bien se défendre. Confronté à un appareil bureaucratique aussi absurde que proliférant, il ne connaîtra jamais les motifs de l’accusation, sera jugé, puis exécuté « comme un chien ».

En janvier 2020, la police de Détroit menotte Robert Williams sur sa pelouse devant sa femme et ses deux filles terrifiées, âgées de 2 et 5 ans. Il est conduit en centre de détention. On prend ses empreintes digitales, un échantillon d’ADN et sa photo pour l’identité judiciaire. La police refuse de lui dire pourquoi il est arrêté. Il passe sa nuit dans une cellule crasseuse et surpeuplée. L’après-midi suivant, on lui présente des images de vidéo-surveillance montrant un Noir volant des montres dans un magasin de luxe. Aux inspecteurs qui lui demandent « C’est vous ? », il répond : « Non. Vous pensez que tous les Noirs se ressemblent ? ». Trente heures après son arrestation, il est relâché. L’IA de reconnaissance faciale a produit un faux positif. Un inspecteur reconnait que « l’ordinateur s’est trompé ». Robert Williams commente : « Je n’aurais jamais pensé devoir expliquer à mes filles pourquoi leur papa avait été arrêté. Comment expliquer à deux petites filles qu’un ordinateur s’est trompé, mais que la police l’a quand même suivi ? » 19.

Pour Daniel Solove, le Procès de Kafka saisit mieux que 1984, la nature et les effets des relations de pouvoir créées par les bases de données et la manière dont on traite les individus :

Ce que le Procès illustre, c’est que le pouvoir ne s’exerce pas uniquement sous des formes totalitaires, et que les relations de pouvoir déséquilibrées avec des bureaucraties peuvent avoir des effets mortifères sur les individus, quels que soient les objectifs de ces bureaucraties.20

Certes, aux États-Unis, la plupart des gens ne se voient pas signifier qu’ils sont arrêtés sans raison apparente et ne s’attendent pas à être exécutés de manière inattendue un soir… [Mais] Le Procès rend compte du sentiment d’impuissance, de frustration et de vulnérabilité que l’on éprouve lorsqu’une grande organisation bureaucratique dispose d’un dossier détaillé sur votre vie. À tout moment, quelque chose peut arriver à Joseph K. ; les décisions résultent des données du dossier, Joseph K. n’est pas informé, il n’a pas son mot à dire et n’a aucun moyen de se défendre. Il est complètement à la merci du processus bureaucratique.21

Daniel Solove souligne cependant que les « métaphores de Kafka et d’Orwell ne s’excluent pas mutuellement ». Être surveillé et s’auto-censurer n’est qu’un aspect du problème. L’autre aspect est le remplacement du jugement humain par des IA prédictives. C’est là qu’Orwell et Kafka se rencontrent.

Les algorithmes de sécurité

Les services de police aux frontières et de sécurité aéroportuaire utilisent les techniques de reconnaissance faciale, à côté des techniques biométriques (scan de l’iris, empreintes digitales). Pour faire du profilage sécuritaire, les gouvernements exploitent leurs propres données et celles du secteur privé (collectables sur les réseaux sociaux, ou exigibles de certaines entreprises, les banques par exemple, au nom de la sécurité). L’IA élabore des modèles de comportements délictueux et criminels à partir des données agrégées des individus condamnés, même pour une simple infraction. Une fois le modèle testé, les systèmes d’IA prédictives peuvent calculer le degré supposé de dangerosité ou de criminalité d’une personne. Ces IA sont réellement performantes. Et quel voyageur souhaiterait la suppression du contrôle de sécurité des passagers de l’avion dans lequel il embarque ?

Le problème des systèmes d’IA prédictives est qu’elles vont bien au-delà de la détection d’un criminel connu ou recherché. Elles indiquent la dangerosité potentielle de tout voyageur, en fonction de « profil » qu’elle lui attribue. Le point commun à ces IA est leur fragilité. D’abord, parce que la décision (refuser l’accès à l’embarquement par exemple), ne résulte pas d’un raisonnement causal à partir des données factuelles et individuelles du moment, mais d’une prédiction de comportement reposant sur des corrélations statistiques et l’algorithme utilisé (le « profil » n’est qu’une prédiction statistique, non le portrait de l’individu réel). Ensuite, parce qu’un grain de sable suffit à faire dérailler ces systèmes : une erreur dans les données, ou une faille du modèle comme dans le cas de Robert Williams (et toujours possible malgré leur efficacité générale). Cathy O’Neil, mathématicienne et data scientist américaine, souligne ce danger :

Si des erreurs apparaissent dans un dossier – et c’est souvent le cas –, les algorithmes même les mieux conçus prendront la mauvaise décision. Comme le disent de longue date les professionnels du traitement de données : « garbage in, garbage out » – si ce qui entre est faux, ce qui sort sera faux.

L’individu qui fait les frais de ce processus automatisé peut en endurer les conséquences pendant des années. Les listes d’interdiction de vol sur des compagnies aériennes pour terrorisme, générées par ordinateur, sont ainsi connues pour regorger d’erreurs. Une personne innocente dont le nom ressemble à celui d’un terroriste présumé affrontera une épreuve infernale chaque fois qu’elle devra monter dans un avion.22

Les conséquences de ces erreurs sont graves. Des personnes peuvent se voir refuser le droit de prendre l’avion ou d’entrer sur un territoire, sans raison ni recours. D’autres, peuvent se voir détenues pour un temps indéfini, sans pouvoir joindre un avocat ni connaître la raison de leur détention. D’autres encore, peuvent être arrêtées ou accusées d’un délit ou d’un crime qu’elles n’ont pas commis. L’IA menace ainsi le principe constitutif des démocraties, à savoir la garantie des droits civils et libertés fondamentales de la personne. Les erreurs entraînant une violation des droits des personnes sont si fréquentes et attendues que, l’UNICRI (United Nations Interregional Crime and Justice Research Institute) et INTERPOL ont dû publier un guide à destination des services de police « pour promouvoir une utilisation responsable de l’intelligence artificielle »23. L’euphémisme « responsable » rappelle que l’intelligence dite artificielle ne l’est pas tant cela, qu’elle commet toujours des erreurs « stupides », et que le jugement humain reste absolument nécessaire pour l’évaluation des situations.

Les algorithmes de surveillance des bénéficiaires d’aides sociales

Les algorithmes de détection des fraudes aux aides sociales sont utilisés dans de nombreux pays, et partout critiqués. Le cas français de la Caisse nationale des allocations familiales est emblématique des dérives de ces IA prédictives (j’utiliserai l’acronyme CAF plutôt que CNAF moins usuel).

En 2024, 29 millions de contrôles automatisés ont été réalisés. On n’a jamais fait mieux. Un tel volume de contrôle n’est réalisable que par des IA capables d’exploiter des mégadonnées (Big Data) et de les croiser par la technique du data mining. Ce succès devrait réjouir, après tout, les fraudeurs mettent en péril le système social. Ce n’est pourtant pas le cas. L’IA prédictive de la CAF souffre des mêmes biais et failles que tous les programmes de ce type. Les problèmes sont si graves et les témoignages si accablants24 que quinze associations, fondations et syndicats ont porté l’affaire devant le Conseil d’État25.

L’algorithme est discriminatoire, il cible les personnes pauvres et vulnérables. Les paramètres de l’algorithme conduisent à présumer systématiquement comme fraudeurs certaines catégories d’allocataires : les personnes à revenus faibles, au chômage, au RSA, les personnes handicapées et les familles monoparentales26. L’algorithme est neutre : une équation mathématique n’a pas d’intention, et la machine (le hardware) n’a pas d’âme ; on peut aussi créditer les ingénieurs de ne pas avoir intentionnellement biaisé le programme pour persécuter les plus faibles. La limite de cette « neutralité » algorithmique est qu’un programme prédictif de ce genre ne peut être que « discriminatoire », parce que statistiquement les bénéficiaires de la CAF sont majoritairement précaires, et que plus la précarité est grande plus le risque statistique de fraude augmente. Mais surtout, l’accroissement des contrôles des catégories ciblées crée une boucle de rétroaction pernicieuse. Multiplier les contrôles des catégories ciblées aboutit mécaniquement à détecter plus de fraudes dans ces catégories ; les nouvelles données nourrissent le système qui ajuste leur score de risque à la hausse, ce qui « justifie », ensuite, un renforcement de la surveillance de ces populations. Fabriquer un système plus juste, impliquerait d’introduire des règles correctives, c’est-à-dire des biais pour corriger les biais résultant des corrélations statistiques du modèle27. Mais est-ce vraiment ce que veulent les gouvernements ? Quoi qu’il en soit, c’est à raison que de nombreuses associations ont dénoncé « la chasse aux pauvres » qu’entraînent ces « machines à soupçon », et l’assimilation entre précarité et fraude.

Décisions automatisées, inhumanité des contrôles. L’algorithme de la CAF décide donc qui sera contrôlé. Les personnes « à risque » subissent une surveillance accrue, une multiplication des contrôles « sur pièces » et « sur place » (à domicile). L’automatisation des décisions, des notifications, l’impossibilité d’avoir un agent — et non pas un « agent conversationnel » ou une réponse « rédigée par une IA », l’impossibilité d’avoir des réponses claires et rapides, génèrent une angoisse permanente. Des allocataires perdus dans la complexité des démarches préfèrent renoncer à leurs droits sociaux ; d’autres, traumatisés par les contrôles à répétition et une incrimination abusive, abandonnent tout recours.

L’enfer des dettes artificiellement créées par le robot de la CAF. Les personnes incriminées à tort voient souvent leurs prestations suspendues, et l’exécution automatisée de la demande de remboursement, par saisie-arrêt sur leur compte bancaire28. Des allocataires brutalement privés du RSA ou d’autres prestations, accumulent des dettes. S’ils saisissent le Tribunal administratif, il faudra deux années avant que la CAF ne soit contrainte à les rétablir dans leurs droits. Agnès Callamard, secrétaire générale d’Amnesty International, alerte sur les conséquences déjà observées :

Nous avons vu ce qui s’est passé aux Pays-Bas en 2021, où le fisc a utilisé un algorithme discriminatoire de notation des risques pour détecter la fraude aux allocations familiales. Des milliers de familles ont été plongées dans la dette et la pauvreté. Une situation similaire risque de se produire en France, et ce risque doit être atténué de toute urgence puisque des préjudices sont déjà survenus.29

La violation des règles de Droit garantissant les droits et libertés des citoyens. La CAF ignore les exigences de transparence et de motivation qui voudraient qu’une décision de suspension d’allocation soit toujours expliquée, avec mention explicite de l’article de loi appliqué. La CAF use le plus souvent de notifications vagues comme « Vos droits ont changé » ou « Nous avons recalculé vos prestations ». Comme dans le Procès ou le Château de Kafka, la décision tombe sur l’allocataire qui cherche en vain à comprendre où est sa faute ou l’erreur de l’administration. Didier Minot, ancien Haut fonctionnaire, président du Changer de cap témoigne :

Dans le meilleur des cas, la personne reçoit une notification d’indu assez sommaire. On a étudié par exemple le cas d’une femme qui a reçu un document dans lequel on lui disait : “Suite au contrôle de votre dossier, nous avons constaté sur vos relevés bancaires que vos grands-parents vous aident régulièrement depuis octobre 2020, or ces sommes n’ont pas été déclarées. Par conséquent nous vous inscrivons comme fraudeuse.” […] Il est indiqué ensuite que la charge de la preuve lui incombe et, en caractères gras, que la loi rend passible d’amende ou d’emprisonnement quiconque se rend coupable de fraude ou de fausse déclaration. Les neuf-dixième des gens sont démunis face à ces documents et n’ont pas les moyens de les contester.30

Saisie, la Défenseure des droits a rendu un avis très sévère contre la CAF qu’elle enjoint de « se conformer aux dispositions du code des relations entre le public et l’administration en motivant en fait et en droit les décisions qu’elle notifie aux allocataires », à « ne pas suspendre les prestations en l’absence d’obstacle au contrôle caractérisé de la part de l’allocataire », à lui fournir « les informations nécessaires afin de pouvoir répondre à un tel contrôle » en « notifiant une décision administrative motivée à l’allocataire » (décision du 26 juin 2024, disponible en ligne). En clair, la CAF est sommée de respecter l’État de Droit.

Joseph K. se plaignant de la CAF à l’ère de Services Publics+

Le Procès,Orson Welles

La plateforme numérique Services Publics+, a été lancée par le Gouvernement pour rendre les services publics plus proches, plus simples et plus efficaces, pour faciliter le contact avec un agent et obtenir des réponses rapides. La plateforme est utile pour obtenir des informations de base. Mais dès qu’un usager rencontre un problème précis, elle devient inutile et même nuisible. Tenons-nous au cas de l’Agence de recouvrement et d’intermédiation des pensions alimentaires (Aripa), liée à la CAF. Un parent qui doit verser une pension doit le faire directement à la CAF. Le service Aripa s’occupe ensuite du versement au bénéficiaire ainsi que de la récupération des pensions impayées. Formidable ! Sauf qu’en réalité, cela se passe souvent mal. Commence alors un dialogue « 2.0 ».

Une allocataire, mère de deux enfants, se plaint d’être restée 9 mois sans pension alimentaire à cause des délais et de l’oubli du rattrapage lors de la régularisation. Elle décide d’écrire à « Services publics+ » :

On fait face à un parent qui ne paye pas et à un service d’intermédiation qui ne paye pas, mais nous on élève nos enfants et on doit les nourrir tous les jours ! C’est inadmissible ! Pourquoi un dossier déjà en place met des mois à être “transférer” ? Je m’interroge. Cette situation est très chronophage et anxiogène. C’est une violence administrative. Depuis que l’Aripa gère on est laissé à l’abandon !

Elle signe « Maman de deux ados ». La réponse est la suivante :

Bonjour Maman de 2 ados, [sic]

Nous avons pris connaissance de votre expérience concernant l’intermédiation des pensions alimentaires et nous sommes désolés pour les difficultés que vous avez rencontrées. (…) Il est important de signaler tout impayé directement à l’Aripa pour enclencher le processus de recouvrement (…) vous pouvez vérifier le suivi avec l’Aripa (…) Nous vous encourageons à vous connecter sur leur plateforme en ligne (…).

Nous vous remercions d’avoir partagé votre situation, cela nous préoccupe et nous permet d’améliorer constamment nos services.

Cordialement.

Ibtissem

Cette réponse a été générée par une IA à 99% et vérifiée par un agent.31

La réponse rédigée à 99% de l’IA renvoie cette mère au service défaillant et la remercie de contribuer « à améliorer constamment [leurs] services ». La bêtise et l’inutilité de la réponse sont patentes. Les réponses de ce type sont légion32. Ce qui n’est pas étonnant puisqu’une IA n’a aucune compréhension des questions qu’elle reçoit, ni des réponses qu’elle renvoie. La réponse est automatiquement générée par un algorithme de complétion statistique33. D’où le renvoi des allocataires à des démarches qu’ils ont, pour la plupart, déjà effectuées sans succès.

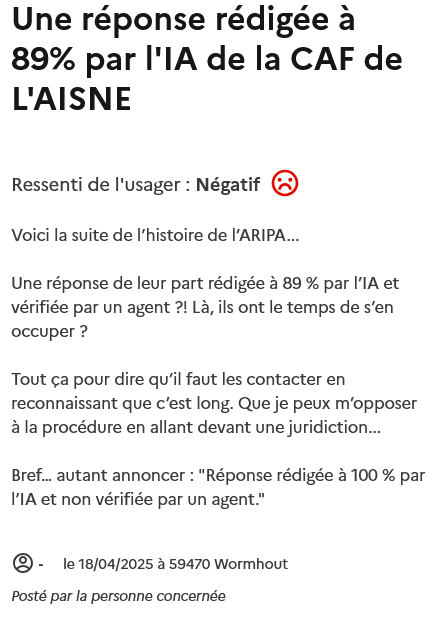

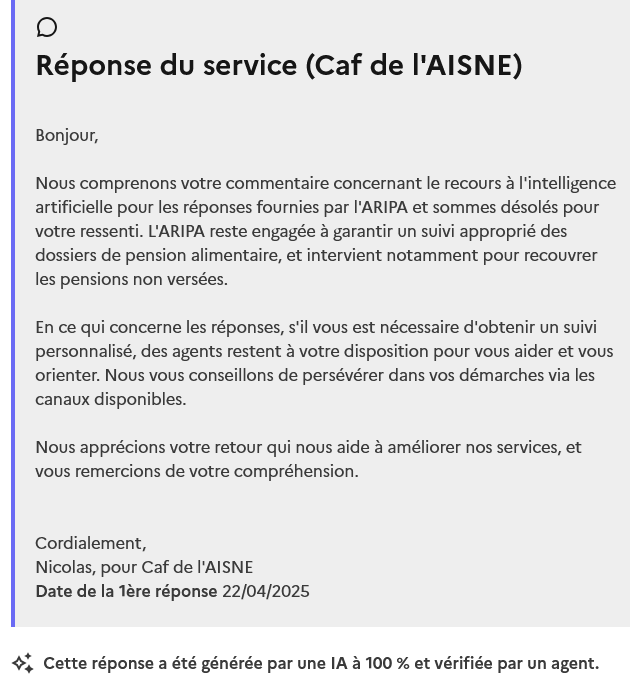

Une autre allocataire se plaint qu’il faille « pratiquement un an pour faire réviser la pension en cas de changement de situation », alors que « dans l’autre sens, il suffit juste d’un courrier pour prélever aujourd’hui plus de 50% de [ses] revenus », que « la CAF ne répond pas aux mails », etc. Elle reçoit elle aussi une pseudo-réponse comprenant la mention « cette réponse a été générée par une IA à 89 % et vérifiée par un agent ». Mécontente, elle livre son « retour d’expérience » :

Une réponse de leur part rédigée à 89 % par l’IA et vérifiée par un agent ?! Là, ils ont le temps de s’en occuper. Tout ça pour dire qu’il faut les contacter en reconnaissant que c’est long. Que je peux m’opposer à la procédure en allant devant une juridiction…

Bref… autant annoncer : “Réponse rédigée à 100% par l’IA et non vérifiée par un agent”."

On comprend la demande implicite : avoir affaire à « un vrai agent » qui considère sa requête avec intelligence et compréhension de sa situation. Là où un agent humain aurait porté plus d’attention à sa demande initiale et à son mécontentement face à la réponse « automatisée », le système génère la réponse suivante :

Nous vous conseillons de persévérer dans vos démarches via les canaux disponibles.

Nous apprécions votre retour qui nous aide à améliorer nos services, et vous remercions de votre compréhension.

Cordialement,

Nicolas, pour Caf de l’AISNE Cette réponse a été générée par une IA à 100% et vérifiée par un agent.34

Ce qui s’appelle se moquer de monde. Quelle est donc la finalité d’une Plateforme comme « Services Publics+ », qui se vante sur sa page d’accueil de posséder toutes les qualités qui lui font défaut ? La plateforme apparaît comme écran supplémentaire entre l’administration et l’usager, elle complique inutilement les démarches et suscite de la frustration puisqu’elle est inefficace. Dans le même temps, l’enquête du Défenseur des droits, publiée le lundi 13 octobre 2025, montre que le taux de Français en difficulté dans les démarches administratives à cause du passage au numérique a explosé en 8 ans, passant de 39% à 61%.35

L’IA de la CAF, un exemple de monde orwello-kafkaien

Les bénéficiaires d’aides sociale sont l’objet d’une surveillance constante couplée à un enfer bureaucratique. La surveillance est disproportionnée. L’algorithme de la CAF analyse chaque mois les données personnelles de plus de 32 millions de personnes, soit près de la moitié de la population française. Suspectés de fraude, les allocataires doivent remplir des montagnes de papiers, répondre à d’innombrables questions, fournir 10 fois le même document, et subir des contrôles inquisitoires, numériques ou à domicile36. La CAF refuse dans le même temps de communiquer le code source de son algorithme actuel, empêchant tout contrôle indépendant et tout débat public informé sur cette utilisation.

La généralisation des décisions algorithmiques

Les décisions algorithmiques concernent un nombre croissant de secteurs, très importants dans la vie des individus. Par exemple, les entreprises confient désormais à des algorithmes l’analyse automatisée :

- de votre demande de prêt bancaire ou d’assurance, pour décider de sa recevabilité selon votre profil ;

- du CV qui accompagne votre demande d’emploi, complété par toutes les données numériques disponibles sur Internet, pour retenir ou écarter votre candidature

Tous ces algorithmes d’IA posent les mêmes problèmes : de fiabilité et de pertinence du traitement (tous produisent des corrélations statistiques réductrices et non pas des analyses causales) ; d’impartialité et de neutralité en raison des biais ; d’opacité des décisions puisque le lien entre les données d’entrée et les résultats est impossible à connaître et de quasi-impossibilité de les contester ; de déresponsabilisation des employés ou agents qui, incapables de comprendre et d’expliquer le processus qui conduit à la décision, ne peuvent la justifier que par une phrase du type « c’est l’ordinateur qui a décidé ».

On trouvera de nombreux exemples du danger des systèmes d’IA prédictives dans divers domaines, notamment celui de la justice, dans le livre de Cathy O’Neil, Algorithmes la bombe à retardement (Arènes, 2018).

Conclusion

Il est tout fait possible d’aborder l’IA dans le cadre d’un cours de philosophie politique. Les programmes de notions sont tellement vagues que l’enseignant a l’embarras du choix : La Justice, L’État, La Liberté, La Raison, La Technique, La Science. Même si l’IA a renouvelé les manières de surveiller et de punir, les analyses de Foucault et d’Orwell restent pertinentes.

On peut aussi se servir de références plus classiques. Par exemple, passer diverses utilisations de l’IA au crible des notions de « liberté négative » et de « liberté positive », telles qu’Isaiah Berlin les définit, mais indépendamment de ses positions à ce sujet37 :

[Liberté négative] Je suis libre, dit-on généralement, dans la mesure où personne ne vient gêner mon action. En ce sens, la liberté politique n’est que l’espace à l’intérieur duquel un homme peut agir sans que d’autres l’en empêchent. Si d’autres m’empêchent de faire ce qu’autrement j’aurais fait, je ne suis pas entièrement libre ; et si cet espace se trouve réduit en dessous d’un certain minimum, on peut dire que je suis contraint, opprimé et peut-être même asservi. […] Plus vaste est cette aire de non-ingérence, plus étendue est ma liberté.

Isaiah Berlin, Éloge de la liberté (1969), Calmann-Lévy, 1988, pages 171-172

Le sens « positif » du mot liberté découle du désir d’un individu d’être son propre maître. Je souhaite que ma vie et mes décisions dépendent de moi, et non de forces extérieures quelles qu’elles soient. Je désire être l’instrument de ma propre volonté, et non celui de la volonté des autres ; je désire être un sujet et non un objet ; être mû par des raisons et des mobiles conscients qui soient les miens, et non par des causes, pour ainsi dire extérieures. Je désire être une personne et non personne, décider et non qu’on décide à ma place, agir et non être agi par la nature ou par d’autres hommes, comme si j’étais une chose, un animal ou un esclave, incapable d’assumer sa condition d’homme, autrement dit, incapable de concevoir et de réaliser des fins et des stratégies qui lui soient propres.

Isaiah Berlin, Éloge de la liberté (1969), Calmann-Lévy, 1988, page 204.

Le paternalisme est despotique, non pas parce qu’il opprime davantage que la tyrannie à l’état pur, brutale et obscurantiste, non parce qu’il ignore la raison transcendantale qui réside en moi, mais parce qu’il est une insulte à la conception que j’ai de moi-même comme homme qui entend conduire sa vie selon ses fins propres (lesquelles ne sont pas forcément rationnelles ou bien intentionnées) et qui, surtout a le droit d’être reconnu comme tel par les autres.

[…]

Manipuler les hommes, les pousser vers des fins que moi — le réformateur social je discerne — mais eux pas forcément, revient à nier leur essence, à les traiter comme des objets sans volonté propre, en un mot à les avilir. En effet, leur mentir, les tromper, les utiliser comme des moyens pour mes propres fins, même si c’est pour leur bien, revient en fait à les traiter comme des sous hommes, comme si leurs fins étaient moins ultimes et moins sacrées que les miennes. Au nom de quoi puis-je les contraindre à faire ce qu’ils ne veulent pas ? Seulement au nom d’une valeur plus sublime qu’eux.

Isaiah Berlin, Éloge de la liberté (1969), Calmann-Lévy, 1988, pages 204-205.

La « liberté négative » s’oppose à l’oppression, à la contrainte, ainsi qu’à tout paternalisme (au sens classique du terme), à toutes les ingérences et immixtions dans la vie privée ou sa conduite de la part des États et, par extension aujourd’hui, des géants du numérique (Isaiah Berlin ne connaissait pas les GAFAM !). Elle est aussi impliquée dans tous les cas de violations des droits fondamentaux : discriminations, privations illégitimes de droits, restrictions indues de circulation, enferment arbitraire, condamnations sans procès et impossibilité de se défendre.

La « liberté positive » s’oppose au paternalisme du « Nudge » (« coup de pouce »). Le Nudge est une technique qui utilise les biais cognitifs mis en évidence par la psychologie comportementale, pour « aider » les citoyens à adopter les bons comportements. Le Nudge est la plupart du temps bien intentionné38. Son utilisation en politique fait question. D’abord, parce qu’il repose sur l’idée qu’il vaut mieux manipuler psychologiquement les citoyens plutôt que de perdre son temps à discuter ou argumenter pour les convaincre des bienfaits d’une changement de comportement, ce qui revient à renoncer à la politique, ou à l’idéal d’une démocratie participative fondée sur le débat et la délibération rationnelle. Deuxièmement, parce qu’il ne traite pas l’individu comme un sujet capable d’autonomie critique, mais comme un être perclus de biais cognitifs, un être irrationnel et infantile, ce qui justifie de le traiter comme un enfant39. Enfin, parce que les gouvernements comprennent si bien l’intérêt du Nudge qu’ils l’utilisent pour forcer « gentiment » l’acception de certaines réformes (voir le livre d’Audrey Chabal cité ci-dessous), ou fabriquent des « nudges » négatifs (les « sludges »40), par exemple, pour dissuader des usagers d’accomplir certaines démarches en augmentant le coût cognitif et psychologique.

Sur le Nudge en politique, on pourra lire :

1° L’article important que Gerald Dworkin consacre au « Paternalisme » dans la Stanford Encyclopedia of Philosophy41. Il y discute notamment le « paternalisme libertaire » (ou « soft ») dont se réclament Cass Sunstein et Richard Thaler, les théoriciens du Nudge42.

2° L’enquête d’Audrey Chabal, Souriez, vous êtes nudgé. Comment le marketing infiltre l’État, Éditions du Faubourg, 2021. Petit livre pédagogique avec de nombreux cas documentés (le paternalisme libertarien pour gérer la crise Covid) ou la face sombre du Nudge politique (chapitre 3. Sur la « pente savonneuse des nudges »).

3° « Paternalisme digital ? L’apothéose de la gouvernementalité », cinquième chapitre du livre de Philippe Huneman, Les sociétés du profilage. Évaluer, optimiser, prédire, Payot, 2023. Le livre est stimulant et bien documenté, même si son propos parfois un peu rapide mérite discussion.

Serge Cospérec

Notes

-

On pourra se reporter au grand classique de David Lyon, The Electronic Eye : The Rise of Surveillance Society (University of Minnesota Press, 1994). Pour un ouvrage récent et bien fait, voir Gabriel Ganascia, Servitudes virtuelles, Seuil, 2022. Les premières pages de l’introduction à La Société d’exposition, Désir et désobéissance à l’ère numérique (Seuil, 2020) de Bernard E. Harcourt, sont également très stimulantes. En revanche dire que 1984 représenterait un paradigme dépassé, parce que dans les « société d’exposition » la collecte des données est volontaire et le contrôle consenti, est plutôt naïf. Les régimes autoritaires progressent partout dans le monde, y compris en Europe. Ils sont l’exact contraire des « sociétés d’exposition » ; leurs citoyens évitent de communiquer et de s’exposer sur les réseaux qui sont constamment surveillés grâce à l’IA. ↩︎

-

Le titre exact est PANOPTICON or THE INSPECTION-HOUSE, et le sous-titre : containing the idea of a new principle of construction applicable to any sort of establishment, in which persons of any description are to be kept under inspection ; and in particular to penitentiary-houses, prisons, houses of industry, work-houses, poor-houses, lazarettos, manufactories, hospitals, mad-houses, and schools, with a plan of management. L’objectif de Bentham est humaniste : trouver un moyen de maintenir l’ordre sans constamment punir, battre ou supplicier les prisonniers. Foucault ne s’y trompe pas. ↩︎

-

L’ananas « qui possède une centaine d’« yeux » tournés dans toutes les directions, renvoie à la vision panoptique qui permet de tout voir sans être vu, source de tout pouvoir et de toute autorité. Les yeux de l’Angkar sont des espions (« chhlop »), recrutés parmi de jeunes adolescents qui devaient dénoncer les traîtres, y compris leur propre famille. » Commentaire des Yeux d’ananas, peinture de l’artiste cambodgien Bor Hak, dans la revue /art absolument/, n° spécial d’avril 2013, « Création et postmémoire », page 37 [Disponible en ligne]. Un analogue scolaire est la phrase efficace avec des petits :« Attention ! même quand j’écris au tableau, je vous vois ; j’ai des yeux dans le dos ». ↩︎

-

Henri Locard, Le “Petit Livre Rouge” de Pol Pot ou les paroles de l’Angkar, L’Harmattan, 2019, page 88. ↩︎

-

Sur le SCS, on peut se reporter à la première étude publiée en France, celle du chercheur Emmanuel Dubois de Prisque « Le système de crédit social : comment la Chine évalue, récompense et punit sa population », Institut Thomas More, « Note 36 », juillet 2019. [Disponible en ligne]. Je signale le bon documentaire de Sébastien Le Belzic, Ma femme a du crédit, diffusé sur LCP en 2022. ↩︎

-

Chen, Yongxi et Cheung, Anne SY, « The Transparent Self Under Big Data Profiling: Privacy and Chinese Legislation on the Social Credit System », The Journal of Comparative Law, 2017, vol. 12, n° 2, pages 356-378. [Disponible en ligne] ↩︎

-

« Surveiller pour punir : la notation des citoyens chinois », France Culture, 9 janvier 2019. [Disponible en ligne] ↩︎

-

Emmanuel Dubois de Prisque, La Chine et ses démons : Aux sources du sino-totalitarisme, Odile Jacob, 2022, Chapitre VI, « La Chine, le christianisme et la liberté ». ↩︎

-

Pierre Haski, « Elle tweete une horrible blague raciste, sa vie devient un cauchemar », Le nouvel Observateur, 2013. [Disponible en ligne] ↩︎

-

Sur les circonstances : « Peut-on être licencié à cause d’une photo prise à son insu ? », Blog Cadre averti, 2020. [Disponible en ligne]. Sur l’affaire et le jugement final, 3 ans et demi plus tard (!), « Rouen. Licencié après avoir été dénoncé par « un passant », l’éboueur gagne aux prud’hommes », Actu 76, [Disponible en ligne] ↩︎

-

« États-Unis. Licenciements massifs pour ceux qui se sont amusés de la mort de Charlie Kirk », Courrier International, 18 septembre 2025, [Disponible en ligne] ↩︎

-

Jean-François Amadieu, « Quand les élèves notent leurs profs : justice ou consumérisme ? », The Conversation, 22 mars 2022. [Disponible en ligne]. Aux Etats-Unis, une mauvaise note peut conduire au licenciement. C’est la mésaventure arrivée à un professeur chimie réputé de l’Université de New York, à la suite d’une pétition de ses étudiants accusant ses cours jugés trop « difficiles » d’être responsables de leurs mauvais résultats aux examens. (« Méthodes dépassées ou nivellement par le bas ? Un professeur d’université viré pour des corrections trop sévères », La Libre Belgique, 11 octobre, 2022. [Disponible en ligne] »). ↩︎

-

Orwell, 1984, Appendice : « les principes de la Novlangue ». ↩︎

-

C’était aussi un lieu commun du cours de philosophie avec l’exemple des 75, 100 ou 200 mots (supposés) pour parler de la neige chez les Inuits. Sur ce mythe, voir Geoffrey Keith Pullum, The Great Eskimo Vocabulary Hoax and Other Irreverent Essays on the Study of Language, University of Chicago Press, 1991, pages 159-171. [Disponible en ligne] ↩︎

-

Voir Lidia Likhacheva, De la création lexicale au « novlangue » russe : lorsque le monde d’Orwell devient réalité, 2023. [Disponible en ligne] ↩︎

-

Lotus Ruan, Jeffrey Knockel, Jason Q. Ng, and Masashi Crete-Nishihata, One App, Two Systems How WeChat uses one censorship policy in China and another internationally, Université de Toronto, 2016. [Disponible en ligne]. ↩︎

-

Karen Yourish, Annie Daniel, Saurabh Datar, Isaac White, Lazaro Gamio, « The Words Federal Agencies Are Discouraged From Using Under Trump », New York Times, 7 mars 2025. ↩︎

-

Épigraphe de l’Introduction du livre de Mark Coeckelbergh, The Political Philosophy of AI : An Introduction, Cambridge, UK: Polity Press, 2022.(j’ai simplement inversé les deux phrases). ↩︎

-

Il raconte toute l’épreuve dans un éditorial publié par le Washington Post (« I was wrongfully arrested because of facial recognition. Why are police allowed to use it ? » - [En ligne]) et une vidéo publiée par l’American Civil Liberties Union(ACLU) [Disponible en ligne] ↩︎

-

Daniel Solove, The Digital Person. Technology and Privacy in the Information Age, NYU Press, 2004, page 38. ↩︎

-

Même ouvrage, page 41. ↩︎

-

Voir le chapitre « Dommages collatéraux » dans le livre de Cathy O’Neil, Algorithmes la bombe à retardement, Arènes, 2018. ↩︎

-

La présentation du Manuel à l’usage des services chargés de l’application de la loi pour une innovation responsable en matière d’intelligence artificielle en a été faite en 2023 [Accès disponible en ligne à la présentation du manuel (2023) et à sa version révisée (2024)]. ↩︎

-

L’association Changer le Cap en a publié un certain nombre sur son site, disponible en ligne. ↩︎

-

Le Dossier de presse de ces associations est disponible en ligne. Pour un résumé substantiel voir l’article de Didier Dubasque et le résumé des arguments juridiques sur son site « Quinze organisations dont l’ANAS attaquent l’algorithme de notation de la CAF devant le Conseil d’État » (22 octobre 2024). [Disponible en ligne]. ↩︎

-

La démonstration en a été faite en 2023 par l’association La Quadrature du Net. Elle a révélé le 27 novembre 2023 les résultats de son travail dans un article « Notation des allocataires : l’indécence des pratiques de la CAF désormais indéniable » qui secoué les institutions et le monde politique. [Disponible en ligne]. Une enquête conjointe Le Monde-Lighthouse Report a confirmé « les dérives de l’algorithme » des CAF, le profilage et les discriminations : « Profilage et discriminations : enquête sur les dérives de l’algorithme des caisses d’allocations familiales », Le Monde-Lighthouse Report, 4 décembre 2023 [En ligne] Voir aussi l’animation numérique « Comment l’algorithme de la CAF prédit si vous êtes « à risque » de frauder », Le Monde-Lighthouse Report, 4 décembre 2023 [Disponible en ligne] ↩︎

-

Mais, l’idée d’une IA « éthique » est de l’ordre du mythe. Elle soulève des problèmes insolubles. Aucun principe éthique, parce qu’il est un principe, n’est traductible en ligne de code ou instruction d’un programme informatique ; les principes renvoient à des notions bien trop générales (autonomie, bienfaisance, dignité, égalité, justice). Ensuite, il faudrait ensuite établir la liste de ces principes et leur interprétation : qui décidera ? L’IA éthique sert d’argument à ceux qui ne veulent aucune régulation étatique - les GAFAM objectent qu’ils ont déjà tous leurs comités d’éthiques internes. Si on ne peut coder un principe éthique, on peut facilement vérifier si un programme aboutit à des injustices, des discriminations, des atteintes aux droits des personnes, etc. C’est pourquoi la régulation politique des usages de l’IA est en revanche tout à fait possible. Sur l’éthique et l’IA voir l’analyse critique de Gabriel Ganascia dans son livre Servitudes virtuelles, Seuil, 2022. ↩︎

-

Voir le témoignage sur son Blog de la journaliste Lucie Inland, « Comment la CAF a traité mon dossier avec un « robot à dettes », avril 2021 [Disponible en ligne]. Publié initialement par Algorithm Watch (« How French welfare services are creating “robo-debt” ») qui précise que « Au cours des cinq dernières années, plusieurs scandales ont montré l’ampleur du problème. En Australie, 400.000 personnes se sont retrouvées en « robot-dette», 40.000 dans le Michigan et 26.000 aux Pays-Bas. » [Disponible en ligne] ↩︎

-

Amnesty International, « France : l’algorithme de la Caisse nationale des allocations familiales cible les plus précaires », 16 octobre 2024 [Disponible en ligne]. Et suite à l’audit gouvernemental, la ville de Rotterdam a suspendu le système en 2021. ↩︎

-

Voir l’enquête très précise de Radio-France « Quand des algorithmes notent les allocataires de la Caf », 9 décembre 2022. [Disponible en ligne] ↩︎

-

Réponse du 09/09/25. [Disponible en ligne] ↩︎

-

Voir par exemple, la réponse du 29/09/2025 [Disponible en ligne]. Il suffit de taper dans le moteur de recherche du site le nom de ce seul service « Aripa », pour constater le nombre d’allocataire dans des situations dramatiques qui en reçoivent en réalité aucune réponse. ↩︎

-

Pour savoir « Comment fonctionne un agent conversationnel ? », voir article « Melanie Mitchell, L’avenir de l’intelligence artificielle (II-1) ». [Disponible en ligne] ↩︎

-

Réponse du 18/04/2025. [Disponible en ligne] ↩︎

-

Enquête sur l’accès aux droits, 2ème édition, octobre 2025. [Disponible en ligne] ↩︎

-

En témoigne, par exemple, l’article d’Isabelle Rey-Lefebvre dans le Monde du 20 février 2021 titré « “L’entretien avec l’agent de la CAF a été une humiliation” : les bénéficiaires du RSA dans l’enfer des contrôles », qui relate, entre autres, les interrogations d’un contrôleur sur l’usage de 20 € retirés en espèces. ↩︎

-

Voir dans Mark Coeckelbergh, déjà cité, le chapitre 2, « Freedom : manipulation by AI and robot ». ↩︎

-

Par exemple, à Nantes, des poubelles de tri ont été peintes par des street-artistes pour sensibiliser les habitants à la nécessité de trier leurs ordures ménagères. L’exemple canonique est celui de la mouche dessinée au fond d’un urinoir, pour éviter les éclaboussures à l’extérieur de la cuvette en incitant à viser juste. ↩︎

-

À l’exemple du monstre « poubellator » des trains Ouigo et son adresse aux passagers : « j’adore vos déchets », ou de la fausse mouche d’urinoir (cf. note précédente) censée déclencher chez l’homme une irrésistible impulsion à viser juste pour l’anéantir. ↩︎

-

Pour une explication philosophico-pédagogique du sludge, voir le bref article de Nicolas Duffau, « Kézako. Sludge, ces obstacles qui nous engluent » sur Philonomist [Disponible en ligne]. Dans la lignée des « sludges », il y a les « dark patterns », ces interfaces conçues rendre particulièrement infernale l’accès de l’utilisateur à ce qu’il cherche. Une excellente video sur Youtube donne comme exemple le parcours de combattant pour fermer son compte Amazon « How Dark Patterns Trick You Online » [Disponible en ligne] ↩︎

-

Gerald Dworkin, « Paternalism », The Stanford Encyclopedia of Philosophy, 2020. [Disponible en ligne] ↩︎

-

Cass Sunstein et Richard H. Thaler, Nudge : la méthode douce pour inspirer la bonne décision, Vuibert, 2e éd., augmentée, 2022. ↩︎